App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Analog vs. Digital - Unterschied

- Ersteller redtie

- Erstellt am

-

- Schlagworte

- analog digital recording tonaufnahme

LoboMix

Helpful & Friendly User

- Zuletzt hier

- 16.04.24

- Registriert

- 23.01.15

- Beiträge

- 3.729

- Kekse

- 53.580

Dazu bitte ich um einen Nachweis bzw. entsprechende Quellen.In real existierenden Übertragungssystemen wird zwar bei höheren Frequenzen die Qualität schlechter. Aber selbst dann können noch beliebig hohe Frequenzen nachgewiesen werden.

Meiner Kenntnis nach sind alle, ausnahmslos alle real existierenden Übertragungssysteme bandbreitenbegrenzt und unlimitierte Bandbreiten sind technisch nicht realisierbar aufgrund der begrenzenden Eigenschaften der Halbleiter, Leitungen usw.

Das betrifft unterschiedslos analoge und digitale Systeme.

Dazu ist eine Bandbreitenbegrenzung üblicherweise auch sinnvoll und technisch gewollt, da mit einer größeren Bandbreite auch das Rauschen im System ansteigt. Oszilloskope mit größeren Bandbreiten (etwa über 20-50 MHz) hatten und haben deshalb immer eine zuschaltbare Bandbreitenbegrenzung, damit vor allem schwache Signale besser, d.h. rauschärmer erfasst und dargestellt werden können.

Ein anderes Beispiel: Im Mikrowellenherd wird das Mikrowellensignal (Frequenz 2,4 Gigahertz) z.B. über einen Hohlleiter in den Garraum geleitet und nicht über ein Kabel, weil letzteres eine viel zu hohe Verlustleistung hätte. Statt der Garguts würde sich das Kabel erhitzen. Die Bandbreite des Hohlleiters ist auf die Mikrowellenfrequenz abgestimmt und limitiert. Damit kann es die hohe Leistung nahezu verlustfrei übertragen.

Mfk0815

PA-Mod & HCA Digitalpulte

Das ist aber nicht das Thema. Es geht um das Prinzip Analog vs. Digital.Nach Jahrzehnten der Entwicklung darf man die digitale Audio-Technik mit Fug und Recht als erheblich präziser, linearer und zuverlässiger bezeichnen als es die analoge Audio-Technik jemals war.

auch das ist nicht das Thema. Nur weil man bei einem Motor einen Drehzahlbegrenzer verwendet heisst das nicht dass der Motor nicht höher drehen kann (ohne die mögliche Dauer zu berücksichtigen). Und es erklärt schon gar nicht den Unterschied zwischen Windrad und Verbrennungsmotor.Dazu ist eine Bandbreitenbegrenzung üblicherweise auch sinnvoll und technisch gewollt, da mit einer größeren Bandbreite auch das Rauschen im System ansteigt.

Telefunky

Registrierter Benutzer

- Zuletzt hier

- 16.04.24

- Registriert

- 25.08.11

- Beiträge

- 17.216

- Kekse

- 53.633

Sie ist aus der Sicht der Messpunkte-Abtaststung tatsächlich existent... aber: die Strategie, die der ganzen Sache zugrunde liegt, geht von praktischen Verhältnissen aus und unterstellt dem Signal eine gewisse Kontinuität.Das ist prinzipiell so, egalo die Abtastfrequenz 10 Hz, 48kHz, 768 kHz oder 900 tHz ist. Je höher desto kleiner ist die Lücke aber sie ist existent.

Ich wüsste auf Anhieb kein Klang-Beispiel, wo Impulse in derart kurzer Folge entstehen, dass sie in 'in die Lücke' passen würden.

In der Messtechnik an digitalen Schaltungen sieht das anders aus, aber die hat auch eine grundsätzlich andere Zielrichtung.

nasi_goreng

Registrierter Benutzer

- Zuletzt hier

- 15.04.24

- Registriert

- 21.10.08

- Beiträge

- 2.847

- Kekse

- 20.628

Hey, da habt Ihr jetzt dem TE wirklich geholfen.

Und für Euer Ego war der Thread bestimmt auch gut.

Und für Euer Ego war der Thread bestimmt auch gut.

LoboMix

Helpful & Friendly User

- Zuletzt hier

- 16.04.24

- Registriert

- 23.01.15

- Beiträge

- 3.729

- Kekse

- 53.580

Schon gar nicht bei internen Abtastraten die im MHz-Bereich liegen.Ich wüsste auf Anhieb kein Klang-Beispiel, wo Impulse in derart kurzer Folge entstehen, dass sie in 'in die Lücke' passen würden.

Die sog. "blind-time" bei Oszilloskopen ist technisch unvermeidbar, auch wieder sowohl bei analogen als auch digitalen Oszilloskopen. Darauf näher einzugehen und auf die Konzepte, wie bei digitalen Oszilloskopen die Nachteile, die damit verbunden sind, kompensiert werden (z.B. durch äußerst umfangreiche Triggermöglichkeiten und spezielle Trigger für seltene Ereignisse) würde den Rahmen hier endgültig sprengen.In der Messtechnik an digitalen Schaltungen sieht das anders aus, aber die hat auch eine grundsätzlich andere Zielrichtung.

Wie ich schon schrieb, geht es ihm um seine Bachelorarbeit, daher vermute ich, dass er eine gewisse Motivation hat, etwas tiefer in die Materie einzudringen.Hey, da habt Ihr jetzt dem TE wirklich geholfen.

Wobei ich zugebe, dass der Verlauf dieses Threads abschreckend wirken kann.

Sorry, wenn meine Ausführungen mit zu dieser ´Schieflage´ beigetragen haben sollten.

G

Gast27281

Guest

Moin!

Irgendwie scheint ihr nicht zu verstehen? @Mfk0815 hat es eigentlich richtig geschrieben und @klaatu hat es auch richtig angeführt.

Zu erst einmal sind analoge Signale Zeit- und Wertkontinuierlich, sie haben in ihrem zeitlichen Verlauf sowie im Amplitudenverlauf keine Lücke oder eine Unterbrechung!

Wandelt man jetzt so ein Signal digital um, erstellt man eine binäre Zahlenfolge. Dazu muss dem analogen Signal intervallmäßig eine Probe entnommen werden, das nennt man abtasten. Das geschieht durch die Faltung des Signals mit der periodischen Folge von Dirac Impulsen, das sogenannte PCM ( Puls Code Modulation).

Jetzt ist das Signal zeitdiskret, heißt, es wird nur zu bestimmten Zeitpunkten, der Abtastperiode, aufgezeichnet. Die Wiederholfrequenz der Impulse ist dann die Abtast oder Samplingfrequenz. Diese muss dann mindestens das doppelte der Bandbreite des abzutastenden Signals haben, das Shannonsche Abtasttheorem. Verstößt man dagegen, werden Stückchen falsch interpretiert. Ist die Abtastfrequenz kleiner als die doppelte Signalfrequenz, dann entsprechen die Abtastwerte einer kleineren als der des ursprünglichen Signals, das nennt man dann Aliasing. Deswegen wird jedes Analogsignal vor der Digitalisierung auf die maximal zulässige Bandbreite, der Nyquistfrequenz, durch einen Tiefpassfilter (Aliasingfilter) begrenzt.

Dementsprechend muß für eine korrekte binäre Zahlendarstellung mit der Amplitude des Signals verfahren werden. Wobei auch hier wieder aus einem wertkontinuierlichem ein wertdiskretes Signal gemacht wird. Dabei kann die Amplitude nur noch ganz bestimmte Werte annehmen, das nennt man Quantisierung. Der Amplitudenbereich wird dazu in Stufen aufgeteilt. 16 Bit, sind 16 binäre Stellen, das entspricht der Auflösung 2 hoch 16 = 65536 Stufen, bei 24 Bit sind das dann schon enorme 16777216 Stufen. Damit ist nun die maximale Genauigkeit der Quantisierung gegeben.

So und nun kommt's. Das ist es was @Mfk0815 als "Lücke" bezeichnet.

Alle Amplitudenwerte des Analogsignals die zwischen diese Quantisierungsstufen fallen, werden an die nächstmögliche Stufe angenähert. Es entsteht also ein Fehler! Dieser sogenannte Quantisierungsfehler ist dabei aber nur halb so groß der Quantisierungsstufe, weil eine weiterreichende Abweichung von einer Stufe schon wieder durch die nächste angenähert wird. Wenn die Amplitude des Eingangssignals größer dem Quantisierungsfehler ist, deutlich oberhalb von einem Bit, dann macht sich dieser Fehler als über dem Frequenzbereich gleichmäßigem Rauschen, dem sogenannten Quantisierungsrauschen bemerkbar. Der Rauschspannungsabstand eines A/D Wandlers und die maximale Dynamik entspricht also der Quantisierung. Pro Bit verbessert sich die nutzbare Dynamik um die doppelte Amplitude also um 6dB, womit ein 16Bit Wandler eine theoretische Dynamik von 96dB hätte. Bei kleinen Eingangsamplituden im Bereich des 1. Bits (LSB = least significant bit > geringwertigstes Bit), wird aus dem Nutzsignal eine Rechteckfolge. Das wiederum hat ein diskretes harmonisches Obertonspektrum und es kommt zu tonalen Artefakten dem sogenannten Granulation Noise. Um das zu vermeiden überlagert man das Nutzsignal mit einem Rauschsignal, dem sogenannten Dither. Das Dithersignal ist i.d.R. eine digital erzeugte Pseudozufallsfolge mit einer statischen Spektralverteilung und besitz ungefähr den Pegel der Quantisierungsstufe. Dadurch werden die Artefakte maskiert. Dither werden auch verwendet, wenn die spektrale Wahrscheinlichkeitsdichte dreieckig verteilt ist, was zu besseren Ergebnissen führt. Im Prinzip verschlechtert sich der Rauschabstand durch das Dithering um ungefähr ein Bit, das alsoein 16 Bit Wandler nur noch 90dB Dynamik erreichen kann. Psychoakustisch ist das aber ein Vorteil.

Also hat Mfk immer das richtige geschrieben.

Greets Wolle

Irgendwie scheint ihr nicht zu verstehen? @Mfk0815 hat es eigentlich richtig geschrieben und @klaatu hat es auch richtig angeführt.

Zu erst einmal sind analoge Signale Zeit- und Wertkontinuierlich, sie haben in ihrem zeitlichen Verlauf sowie im Amplitudenverlauf keine Lücke oder eine Unterbrechung!

Wandelt man jetzt so ein Signal digital um, erstellt man eine binäre Zahlenfolge. Dazu muss dem analogen Signal intervallmäßig eine Probe entnommen werden, das nennt man abtasten. Das geschieht durch die Faltung des Signals mit der periodischen Folge von Dirac Impulsen, das sogenannte PCM ( Puls Code Modulation).

Jetzt ist das Signal zeitdiskret, heißt, es wird nur zu bestimmten Zeitpunkten, der Abtastperiode, aufgezeichnet. Die Wiederholfrequenz der Impulse ist dann die Abtast oder Samplingfrequenz. Diese muss dann mindestens das doppelte der Bandbreite des abzutastenden Signals haben, das Shannonsche Abtasttheorem. Verstößt man dagegen, werden Stückchen falsch interpretiert. Ist die Abtastfrequenz kleiner als die doppelte Signalfrequenz, dann entsprechen die Abtastwerte einer kleineren als der des ursprünglichen Signals, das nennt man dann Aliasing. Deswegen wird jedes Analogsignal vor der Digitalisierung auf die maximal zulässige Bandbreite, der Nyquistfrequenz, durch einen Tiefpassfilter (Aliasingfilter) begrenzt.

Dementsprechend muß für eine korrekte binäre Zahlendarstellung mit der Amplitude des Signals verfahren werden. Wobei auch hier wieder aus einem wertkontinuierlichem ein wertdiskretes Signal gemacht wird. Dabei kann die Amplitude nur noch ganz bestimmte Werte annehmen, das nennt man Quantisierung. Der Amplitudenbereich wird dazu in Stufen aufgeteilt. 16 Bit, sind 16 binäre Stellen, das entspricht der Auflösung 2 hoch 16 = 65536 Stufen, bei 24 Bit sind das dann schon enorme 16777216 Stufen. Damit ist nun die maximale Genauigkeit der Quantisierung gegeben.

So und nun kommt's. Das ist es was @Mfk0815 als "Lücke" bezeichnet.

Alle Amplitudenwerte des Analogsignals die zwischen diese Quantisierungsstufen fallen, werden an die nächstmögliche Stufe angenähert. Es entsteht also ein Fehler! Dieser sogenannte Quantisierungsfehler ist dabei aber nur halb so groß der Quantisierungsstufe, weil eine weiterreichende Abweichung von einer Stufe schon wieder durch die nächste angenähert wird. Wenn die Amplitude des Eingangssignals größer dem Quantisierungsfehler ist, deutlich oberhalb von einem Bit, dann macht sich dieser Fehler als über dem Frequenzbereich gleichmäßigem Rauschen, dem sogenannten Quantisierungsrauschen bemerkbar. Der Rauschspannungsabstand eines A/D Wandlers und die maximale Dynamik entspricht also der Quantisierung. Pro Bit verbessert sich die nutzbare Dynamik um die doppelte Amplitude also um 6dB, womit ein 16Bit Wandler eine theoretische Dynamik von 96dB hätte. Bei kleinen Eingangsamplituden im Bereich des 1. Bits (LSB = least significant bit > geringwertigstes Bit), wird aus dem Nutzsignal eine Rechteckfolge. Das wiederum hat ein diskretes harmonisches Obertonspektrum und es kommt zu tonalen Artefakten dem sogenannten Granulation Noise. Um das zu vermeiden überlagert man das Nutzsignal mit einem Rauschsignal, dem sogenannten Dither. Das Dithersignal ist i.d.R. eine digital erzeugte Pseudozufallsfolge mit einer statischen Spektralverteilung und besitz ungefähr den Pegel der Quantisierungsstufe. Dadurch werden die Artefakte maskiert. Dither werden auch verwendet, wenn die spektrale Wahrscheinlichkeitsdichte dreieckig verteilt ist, was zu besseren Ergebnissen führt. Im Prinzip verschlechtert sich der Rauschabstand durch das Dithering um ungefähr ein Bit, das alsoein 16 Bit Wandler nur noch 90dB Dynamik erreichen kann. Psychoakustisch ist das aber ein Vorteil.

Also hat Mfk immer das richtige geschrieben.

Greets Wolle

Mfk0815

PA-Mod & HCA Digitalpulte

Nur du hast das um Klassen besser beschrieben.Also hat Mfk immer das richtige geschrieben.

Ralphgue

Registrierter Benutzer

- Zuletzt hier

- 23.02.21

- Registriert

- 08.01.17

- Beiträge

- 4.864

- Kekse

- 21.047

Es ist ja "schön", wie viele Menschen hier tief gehende Kenntnisse haben...

Die "Kunst des Lehrens" (Didaktik) wäre hier ein Ansatzpunkt zur Beantwortung und nicht das Gegenseitige "hoch schaukeln" einiger "Spezialisten", mehr oder minder zu deren Selbstzweck, die allesfalls beim TE ein Dutzend weitere Fragezeichen aufwerfen.

aber kann einer von euch vielleicht mal auf die Frage des TE eingehen, und zwar so, das ein "Normalsterblicher" eine Grundahnung der Zusammenhänge und Funktionsprinzipien verstehen kann.Das Dithersignal ist i.d.R. eine digital erzeugte Pseudozufallsfolge mit einer statischen Spektralverteilung und besitz ungefähr den Pegel der Quantisierungsstufe.

Die "Kunst des Lehrens" (Didaktik) wäre hier ein Ansatzpunkt zur Beantwortung und nicht das Gegenseitige "hoch schaukeln" einiger "Spezialisten", mehr oder minder zu deren Selbstzweck, die allesfalls beim TE ein Dutzend weitere Fragezeichen aufwerfen.

G

Gast27281

Guest

Die "Kunst des Lehrens" (Didaktik) wäre hier ein Ansatzpunkt zur Beantwortung und nicht das Gegenseitige "hoch schaukeln" einiger "Spezialisten", mehr oder minder zu deren Selbstzweck, die allesfalls beim TE ein Dutzend weitere Fragezeichen aufwerfen.

Ich denke wer eine fachspezifische Bachelorarbeit schreibt, der versteht schon was ich geschrieben habe. Und dieses Thema kann man kaum beantworten ohne ins Detail zu gehen. Was dabei rum kommt hat man ja gesehen. Mfk hat es die ganze Zeit mit "normalen" Worten versucht.

Aber du darfst es gern auch versuchen.

Greets Wolle

adrachin

Registrierter Benutzer

So und nun kommt's. Das ist es was @Mfk0815 als "Lücke" bezeichnet.

Ja. er bezeichnet das so. Was Du danach beschreibst, ist der Prozess, bei dem die digitalen Artefakte entstehen, die als Quantisierungsrauschen bekannt sind Eine Lücke ist das aber nicht. Immer noch kommt nach der Rückwandlung die Wellenform raus, die man vorne reingeschickt hat. Begrenzt durch die technischen Daten des Wandlers.

Allerdings mit weit weniger Artefakten als bei einer analogen Signalbearbeitung. Ein Grund dafür ist unter anderem, das alle mir bekannten DAW mir 32 Bit floating Point rechnen und bei der Bearbeitung daher keine nennenswerten Artefakte hinzukommen.

Betrachtet man einfach nur was vorne reingeht und was hinten rauskommt wird man keinen signifikanten Unterschied feststellen können. Das hat ja der Mensch in dem anfänglich verlinkten Video auch anschaulich dargestellt.

Die von Dir verwendeten Fachbegriffe sind übrigens sicher gut und wichtig für eine wissenschaftliche Betrachtung des Themas.

Weitere Vertiefungen finden sich hier:

Digitale Schaltungstechnik/ Was heißt digital/ Mathematische Definition

und hier:

IDEALE ABTASTUNG UND IDEALE REKONSTRUKTION

mit jeder Menge zusätzlichem Wissen zum Thema digitale Abtastung.

aber kann einer von euch vielleicht mal auf die Frage des TE eingehen, und zwar so, das ein "Normalsterblicher" eine Grundahnung der Zusammenhänge und Funktionsprinzipien verstehen kann.

dubbel

Registrierter Benutzer

- Zuletzt hier

- 16.04.24

- Registriert

- 13.07.13

- Beiträge

- 9.004

- Kekse

- 26.174

Lücke, Fehler, Interpolation...

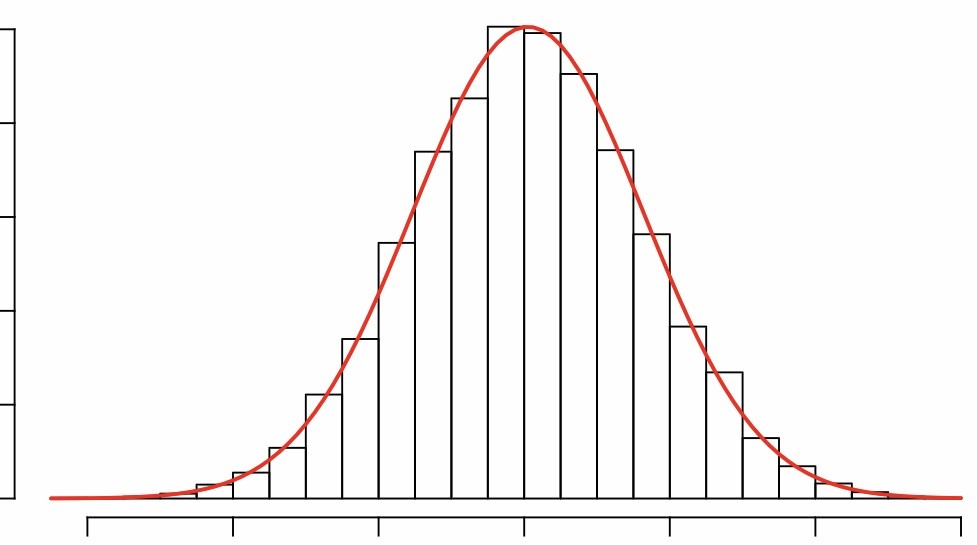

Kann das weiterhelfen? (zwar keine Sinusschwingung, aber immerhin kurvig...)

Kann das weiterhelfen? (zwar keine Sinusschwingung, aber immerhin kurvig...)

LoboMix

Helpful & Friendly User

- Zuletzt hier

- 16.04.24

- Registriert

- 23.01.15

- Beiträge

- 3.729

- Kekse

- 53.580

So in etwa sehen typische Visualisierungen der Quantisierung aus. Noch anschaulicher finde ich aber diese Visualisierung aus dem Video von Xiph.org (Link dazu in Post 5):Kann das weiterhelfen?

Hier werden die einzelnen Samplepunkte dargestellt und wie sie sich auf der Sinsukurve verteilen. Ebenso ist der zeitliche Abstand zwischen den Samples zu erkennen (also die ominösen "Lücken"). Das kommt dem Prinzip der Quantisierung näher als die Darstellung mit Treppenstufen, denn diesen treppenartigen Verlauf gibt es in der Tat nicht, wie in dem Video ausdrücklich erwähnt wird.

Was in an all diesen Darstellungen problematisch finde und was ich hier auch immer betont habe, ist, dass sie leicht irreführend sein können in dem Sinne, dass der Eindruck entsteht, es würden in dem digitalen Datenstrom Informationen fehlen, dieser sei also "lückenhaft". Im Internet finden sich tonnenweise Posts, wo eben diese irrtümliche Vorstellung verbreitet wird und den Eindruck erwecken, dass die digitale Wandlung und Aufzeichnung in sich "fehlerhaft" sei und deshalb schlecht klingen würde.

Diese verbreiteten Irrtümer waren seinerzeit für Monty Montgomery von Xiph.org der Anlass, dieses ausführliche Video zu erstellen. Dort wird auch recht anschaulich das Prinzip und die Wirkungsweise des Dithering erklärt.

Unter der Berücksichtigung, dass durch geeignete Maßnahmen (Filter / Oversampling) Alisaing vermieden wird, gilt uneingeschränkt, was @adrachin oben formuliert hat:

Betrachtet man einfach nur was vorne reingeht und was hinten rauskommt wird man keinen signifikanten Unterschied feststellen können. Das hat ja der Mensch in dem anfänglich verlinkten Video auch anschaulich dargestellt.

Das von @WolleBolle oben erklärte Quantiserungsrauschen und der "Granulation Noise" sind technisch unvermeidliche Erscheinungen bei der AD-Wandlung (es gibt noch weitere, wie z.B. ein winziger Ripple im Frequenzgang, also extrem winzige Unebenheiten im Frequenzgang). Dabei liegt das Quantisierungsrauschen bei einem 16-bit/44,1 kHz-Wandler bei nur -90 dB (siehe hier: https://www.itwissen.info/Quantisierungsrauschen-quantization-noise.html), bei aktuellen 24-bit-Wandlern noch deutlich darunter. Ebenso liegen alle anderen Fehler/Verzerrungen usw. bei halbwegs aktuellen Wandlern bei traumhaften Werten um -100 dB und darunter, zum Teil deutlich darunter. Hier ein Link zum AD-Wandler, der in den Behringer X32-Serien verwendet wird (Crystal cs5368 von Cirrus Logic, THD-Werte auf Seite 12): https://www.mouser.com/datasheet/2/76/CirrusLogic_CS5368_F5-1160035.pdf.

Da Noise und THD ein Maß für die faktische Verfälschung eines Signals darstellen, darf man sagen, dass trotz der erwähnten prinzipbedingten "Mängel" der digitalen Technik diese die Signale sauberer und unverfälschter abbildet als die ´lückenlose´ analoge (Aufzeichnungs-)Technik, da diese dem Signal mehr Verzerrungen und Rauschen hinzufügt.

@klaatu hat es hier auf den Punkt gebracht:

Das ist aber in keiner Weise zum Nachteil dieser Technik, im Gegenteil.Digital ist zeit- und wertdiskret, analog nicht.

Astronautenkost

HCA Mikrofone

- Zuletzt hier

- 15.04.24

- Registriert

- 05.11.03

- Beiträge

- 9.236

- Kekse

- 11.112

Bitte doch zu bedenken, dass es hier um eine Bachelorarbeit (also Studium) geht. Da sollte eine bestimme Auffassungsfähigkeit doch vorhanden sein.aber kann einer von euch vielleicht mal auf die Frage des TE eingehen, und zwar so, das ein "Normalsterblicher" eine Grundahnung der Zusammenhänge und Funktionsprinzipien verstehen kann.

Signalschwarz

Gesperrter Benutzer

- Zuletzt hier

- 26.11.23

- Registriert

- 19.02.11

- Beiträge

- 11.664

- Kekse

- 22.834

Es ist ja "schön", wie viele Menschen hier tief gehende Kenntnisse haben...

aber kann einer von euch vielleicht mal auf die Frage des TE eingehen, und zwar so, das ein "Normalsterblicher" eine Grundahnung der Zusammenhänge und Funktionsprinzipien verstehen kann.

Die "Kunst des Lehrens" (Didaktik) wäre hier ein Ansatzpunkt zur Beantwortung und nicht das Gegenseitige "hoch schaukeln" einiger "Spezialisten", mehr oder minder zu deren Selbstzweck, die allesfalls beim TE ein Dutzend weitere Fragezeichen aufwerfen.

Grundsätzlich richtig, aaaber im speziellen Fall will jemand eine Bachelorarbeit schreiben und da muss er eine solche Informationstiefe bewältigen können bzw. wenn seine Ausbildung oder sein "Studium" was taugen würde, dann hätte er das alles schon währenddessen erfahren sollen. Ich tippe auf SAE Deutschland oder ein ähnliches Institut. Oder einfach Lehreinheit verschlafen oder nicht hingegangen.

dubbel

Registrierter Benutzer

- Zuletzt hier

- 16.04.24

- Registriert

- 13.07.13

- Beiträge

- 9.004

- Kekse

- 26.174

Oder vielleicht war er da gerade Kreide holen.

G

Gast27281

Guest

Oder vielleicht war er da gerade Kreide holen.

Das heißt heute Datenvolumen nachladen!

Greets Wolle

LoboMix

Helpful & Friendly User

- Zuletzt hier

- 16.04.24

- Registriert

- 23.01.15

- Beiträge

- 3.729

- Kekse

- 53.580

Sehe ich auch so. Für eine Bachelorarbeit, in der auf den Unterschied zwischen analogen und digitalen Aufzeichnungsverfahren eingegangen werden soll, sollte das Grundwissen schon über die reine Definition "kontinuierlich/Spannungsverläufe vs. diskret/Nullen und Einsen" hinausgehen und von der Nyquist-Frequenz und Aliasing/Tiefpass/Bandbreitenbegrenzung, dazu noch Quanisierungsrauschen sollte man auch schon gehört haben.Grundsätzlich richtig, aaaber im speziellen Fall will jemand eine Bachelorarbeit schreiben und da muss er eine solche Informationstiefe bewältigen können bzw. wenn seine Ausbildung oder sein "Studium" was taugen würde, dann hätte er das alles schon währenddessen erfahren sollen.

Da es wie eingangs erwähnt, auch um die Geschichte der Tonaufzeichnung gehen soll, könnte diese Website von Interesse sein: http://www.tonbandmuseum.info/

Heute eher eine Kuriosität, damals aber eine wichtige und zudem verbreitete Technik war die magnetisierbare Schallplatte (analog natürlich), eine Spezialität (wenn nicht Monopol) der Firma Assmann Bad Homburg, siehe hier: http://www.tonbandmuseum.info/historie-assmann.html

Ganz gewiss ein Muss für die Betrachtung der Geschichte der Tonaufzeichnung sind die Seiten dort über AEG-Telefunken, siehe ab hier: http://www.tonbandmuseum.info/aeg-telefunken.html

Zuletzt bearbeitet:

Ähnliche Themen

-

-

-

Digitale Audiospeicherung: Rohdaten, verlustfreie und verlustbehaftete Komprimierung

Digitale Audiospeicherung: Rohdaten, verlustfreie und verlustbehaftete Komprimierung- Gestartet von livebox

- Antworten: 9

-

[Effekt] Cuvave / Ammoon Cube Sugar Analog/Digitaler Multieffekt mit IR Loader

[Effekt] Cuvave / Ammoon Cube Sugar Analog/Digitaler Multieffekt mit IR Loader- Gestartet von Korken

- Antworten: 2

-

G

Quick Links

-

Win 10 oder Win 11?

- Gestartet von topo

- Antworten: 5

- Plauderecke

-

Ein professionelles Studio bauen ? Warum eigentlich nicht - Los gehts !

- Gestartet von gitarrenaxl

- Antworten: 77

- Plauderecke

-

Recording-Stammtisch

- Gestartet von livebox

- Antworten: 9K

- Plauderecke

Unser weiteres Online-Angebot:

Bassic.de · Deejayforum.de · Sequencer.de · Clavio.de · Guitarworld.de · Recording.de

Bassic.de · Deejayforum.de · Sequencer.de · Clavio.de · Guitarworld.de · Recording.de