J

Johnny Buttler

Registrierter Benutzer

- Zuletzt hier

- 03.07.14

- Registriert

- 01.06.06

- Beiträge

- 241

- Kekse

- 63

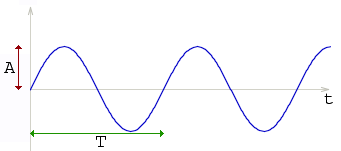

In einem vorherigem Thread über die Rockson Box ist das Wort Phasenauslöschung gefallen.

Soviel ahnung hab ich dann doch nicht um mir die Frage selbst zu beantworten also bitte (Danke fürs) Posten

Gurß Johnny

Soviel ahnung hab ich dann doch nicht um mir die Frage selbst zu beantworten also bitte (Danke fürs) Posten

Gurß Johnny

- Eigenschaft