GinMonotonic

Registrierter Benutzer

- Zuletzt hier

- 17.01.26

- Registriert

- 10.03.23

- Beiträge

- 111

- Kekse

- 110

Anbei mein Erfahrungsbericht über die Erstellung von Musikvideos für den Youtube-Kanal unseres Musikprojekts.

VERWENDETE HARDWARE:

Windows 10

Intel i5-12500 3.00 GHz

Crucial RAM 16GB (2x 8GB) DDR5 4800MHz

MSI GeForce GTX 1650 4GT LP OC

Angefangen habe ich mit der Onboard Grafikkarte Intel UHD Graphics 770 und 8GB RAM. Das Hardwareupgrade war kein Quantensprung. In wie weit ich mit der neuen Grafikkarte besser fahre, muss noch geprüft werden. Eine Bessere steht mir derzeit nicht zur Verfügung, da ich einen kleinen Tower habe, sodass ich nur Grafikkarten im Low Profile Format einbauen kann, also steht nur der Vergleich an, ob ich mit der UHD 770 und mehr RAM doch nicht besser bedient bin. Bis irgendwann etwas nennenswert Besseres, in entsprechender Bauform, auf den Markt kommt.

Die RAM-Verdopplung hat nur marginale Verbesserungen gebracht. Bei Schnitten und/oder Übergängen von großen Videos, sowie beim Einsatz von umfangreicheren Effekten, gibt es weiterhin Ruckler und/oder Aussetzer im Vorschaufenster, weshalb ich hier mindestens 24GB empfehlen würde und selbst bei nächster Gelegenheit auf 32GB upgraden werde.

VERWENDETE SOFTWARE:

Vergangenes Jahr habe ich angefangen, mich näher mit der Videobearbeitung zu beschäftigen. Nachdem ich mehrere kostenlose Programme ausprobiert habe, fiel die Entscheidung auf DaVinci Resolve 18. Den Einstieg fand ich erstaunlich einfach. Kurzes Tutorial angeschaut, um die Struktur zu kapieren und schon konnte es losgehen.

DaVinci ist sehr aufgeräumt, umfangreich und logisch aufgebaut. Die Dosierung von Effekten sowie einfachen Funktionen wie Zoom, ist sehr schön gelöst, sodass man sie präzise setzen und kontrollieren kann. Selbst die kostenlose Version bietet genug hochwertige Effekte/Übergänge und Möglichkeiten der Farbanpassungen, sowie vieles mehr, was ich noch nicht kennengelernt/gebraucht habe. Bei meiner Arbeitsweise wäre der Kauf der Vollversion eine Geldverschwendung, wobei ich den Preis akzeptabel finde.

Die kostenlose Version ist gegenüber der Vollversion in manchen Sachen natürlich etwas eingeschränkt. In wie weit diese den eigenen Ansprüchen gerecht werden, muss individuell geprüft werden. Hierzu gibt es unzählige Webseiten und Videos, die diese Entscheidung erleichtern. Die für mich wichtigsten Punkte sind: Die Einschränkung auf max. 60 FPS und 4K.

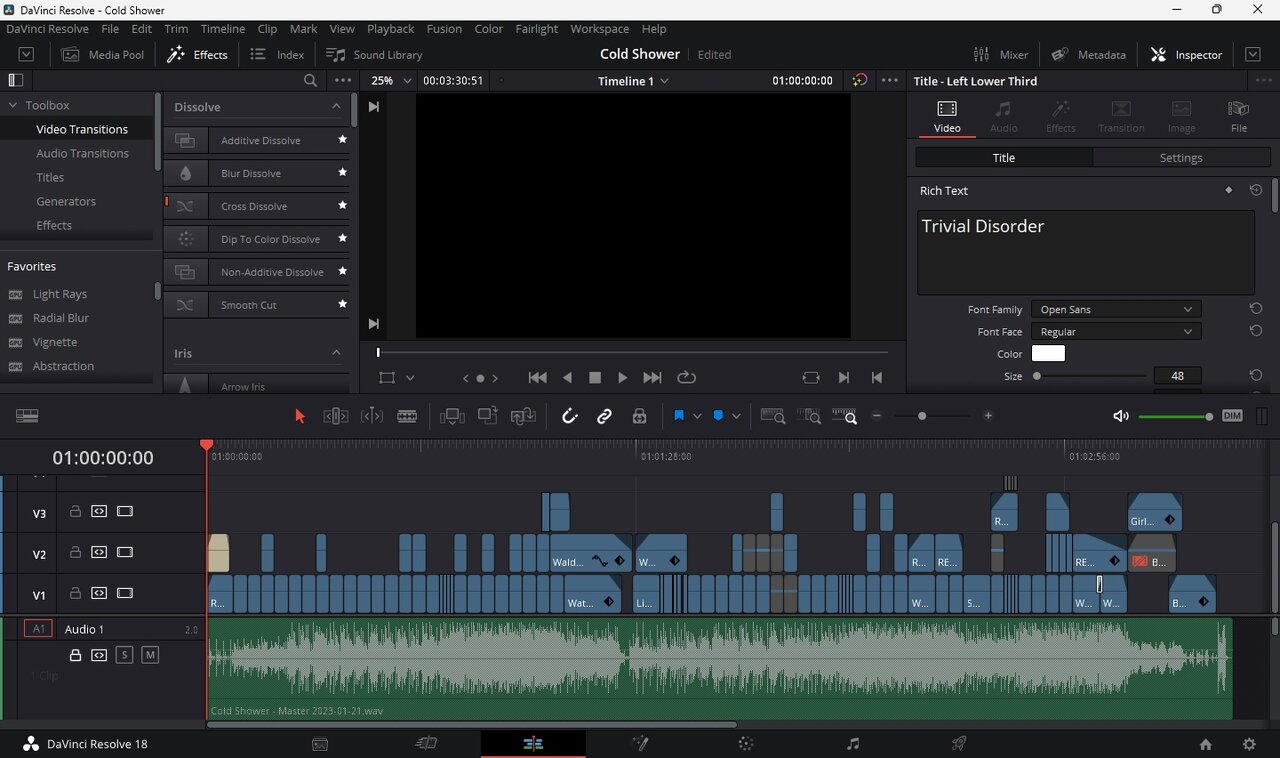

Projektfenster von "Cold Shower":

EIGENARTEN DIESER SOFTWARE:

Wie jede andere Software, bringt auch DaVinci Resolve 18 einige Eigenarten mit. Wenn man es gewohnt ist, mit der ENTF-Taste zu löschen, sollte man sich bei "Keyboard Customization" einstellen, dass diese Taste den "Selected Delete" anstatt "Ripple Delete" ausführt. Beim Letzteren entsteht nämlich keine Lücke nach dem Löschen, sondern die nachfolgenden Videos rutschen nach, was logischerweise das ganze Projekt durcheinander bringt. Dieses Missgeschick in der Verbindung mit dem "Live Save" sorgte mal dafür, dass ich ein Projekt neu anfangen musste. Danach schaltete ich "Live Save" aus und aktivierte stattdessen die Backups. Wer schon länger mit dem PC arbeitet, wird den STRG+S Befehl verinnerlicht haben und braucht diesen Automatismus, bei dem es kein Zurück mehr gibt, nicht.

Meiner Internetrecherche nach, hat DaVinci nicht gerade den besten H.264 Codec an Board. Dies macht sich bei schnellen Helligkeitswechseln bemerkbar. Die gerenderten Videos weisen an solchen Stellen grobe Pixel auf. Einige vermeintlichen Experten auf YouTube raten es ins Quicktime Format, mit dem Codec DNxHD oder DNxHR zu rendern, und es anschließend mit einer anderen Software in mp4 H.264 umzuwandeln. Ich bin aber kein Freund von Umwandlungen.

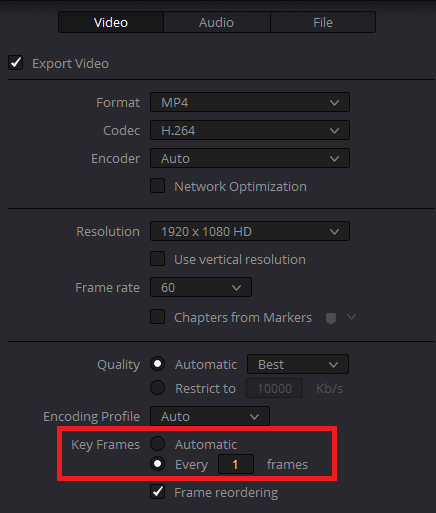

Einfacher und qualitativ besser geht es indem man bei den Rendereinstellungen die Key Frames auf "Every 1 Frame" setzt. Dadurch wird zwar die Datei doppelt so groß, aber fehlerfrei, ohne dass man sie vergewaltigt. So als Orientierung: Ein Musikvideo in HD Qualität (1080p), mit ca. 3,5min Länge, wäre dann ca. 1GB groß. In der heutigen Zeit dürfte das zu verkraften sein.

Diese Einstellung findet man hier:

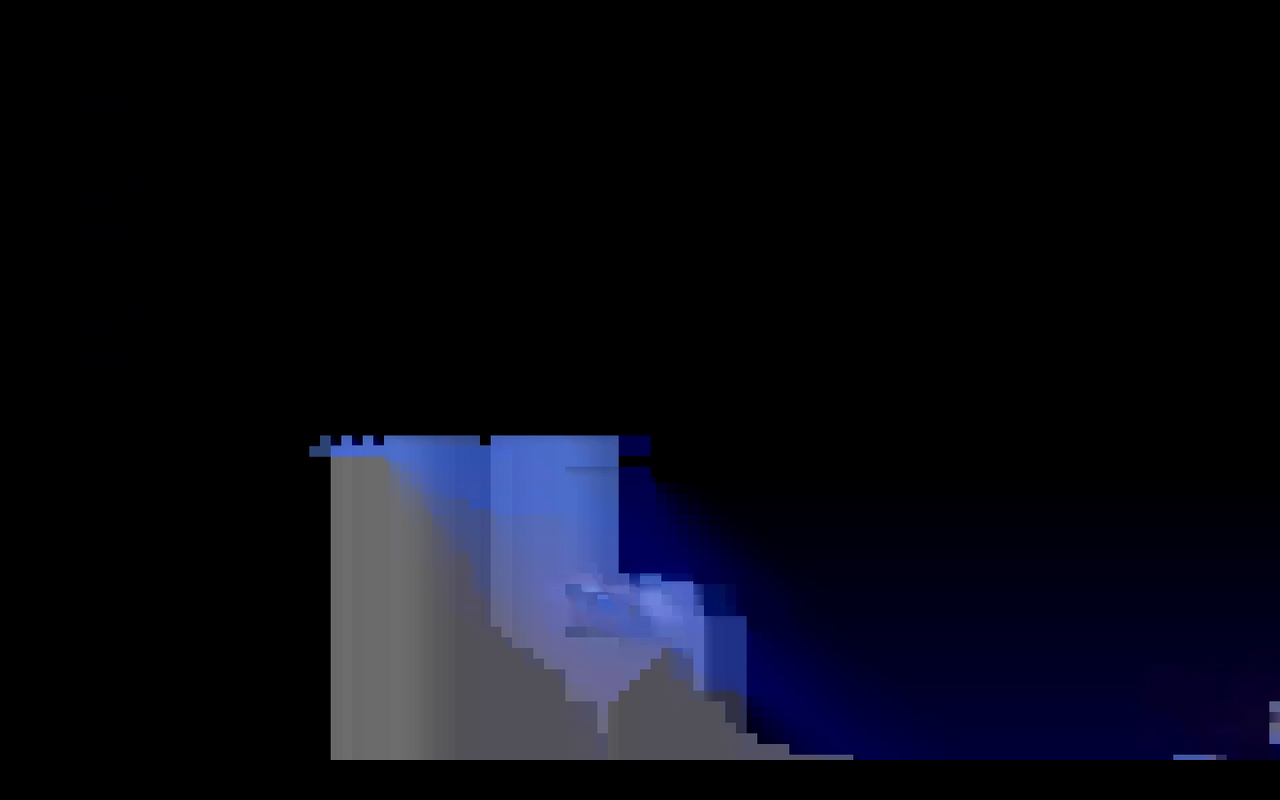

So sieht ein Blitzeinschlag aus, wenn man die Key Frames nicht auf 1 gesetzt hat:

MEINE ARBEITSWEISE:

Da ich für eigene Aufnahmen keine Zeit, Lust, Erfahrung, Ausrüstung, Helfer u.a. habe, entschied ich mich unsere Musikvideos mit dem, in Netz frei verfügbaren, Videomaterial zu schneiden. Momentan bin ich bei der Fertigstellung des dritten Musikvideos. Das Erste ist seit November 2022 auf YouTube, das Zweite seit Mitte Februar 2023 und das Dritte kommt irgendwann, wenn der Song so weit wird.

Mit fremdem Material etwas Eigenes zu machen, kann sowohl sehr einfach, als auch sehr kompliziert sein. Je nachdem welche Ziele man sich setzt. Einfach ist es in dem Sinne, dass man nichts selbst drehen muss und somit ein großer, schwerer, zeitaufwändiger und fast wichtigster Aufgabenteil wegfällt. Kompliziert wird es dann, wenn nicht genug passendes Material gefunden wird. Das Material zusammenzusuchen ist eine Fleißarbeit und alles so zu schneiden, dass es halbwegs stimmig aussieht, ist oft eine Glückssache. Den Kommentaren zufolge, die ich zu den Videos bekam, scheint mir dieser Spagat gelungen zu sein, aber das ist oft Geschmackssache. Ich selbst finde sie für den vorgesehenen Zweck ok.

HABEN SIE VERSTÄNDNIS FÜR FPS:

Ein Musikvideo zeichnet sich unter anderem dadurch aus, dass die Clips im Rhythmus geschnitten sind, also die Schnitte im Beat erfolgen, und ein Videobearbeitungsprogramm zeichnet sich dadurch aus, dass er in FPS (Bilder pro Sekunde) arbeitet. Anders als in der DAW, wo man in BPM arbeitet und dennoch sehr feine Einstellungen vornehmen kann, erlauben die Videoprogramme tatsächlich nur so viele Schnitte in der Sekunde, wie sie im Projekt eingestellt sind.

Bei 30, 60, 120, 180 oder 240BPM sind diese beiden Einheiten synchronisiert und es kann so gut wie nichts schief laufen. Doch sobald man davon abweicht, muss man Kompromisse eingehen und den Schnitt etwas vor- oder zurücksetzen. Also: Je mehr FPS in der Videobearbeitung zugelassen sind, umso präziser können die Schnitte gesetzt werden.

Wie bereits erwähnt, kann man in der kostenlosen Version von DaVinci Resolve 18 max. 60FPS einstellen. Das ist gerade so genug, um einigermaßen genau arbeiten zu können.

ARBEITSERLEICHTERUNG:

Es kann unglaublich nervig und unnötig zeitaufwendig sein, die Clips manuell auf die passende Länge zu schneiden und/oder auf die richtige Position zu platzieren, weshalb man sich zuallererst Gedanken darüber machen sollte, wie man sich die Arbeit vereinfachen kann.

Vor ca. 15 Jahren, als ich kurz mit Adobe Premiere experimentierte, wurde mir empfohlen die Marker im Beat zu setzen. Wenn ich mich richtig erinnere, erfolgte das so, dass man die Audiodatei einfügte, Play drückte und dort wo die Schnitte hinkommen sollten, die Taste M drückte. Später durfte man die ungenauen Marker zurechtrücken oder löschen und neu setzen. Meine Begeisterung für diese Empfehlung hielt sich in Grenzen, da es aber nur ein kleines Videoprojekt mit wenigen solchen Schnitten war, nahm ich sie an, doch beim Wiedereinstieg in die Videobearbeitung musste eine neue Lösung her.

Die Empfehlung die ich diesmal bekam war besser, aber immer noch nicht ideal. Ich sollte mir inhaltslose Videosequenzen in der entsprechenden Länge erstellen, sie im Projekt nacheinander reihen und als Marker verwenden. Eigentlich eine ganz gute Idee, aber auf die Umrechnung und zusätzliche Videos in der Timeline hatte ich keine Lust. Außerdem bestand ja weiterhin das Problem mit der Ungenauigkeit aufgrund von FPS.

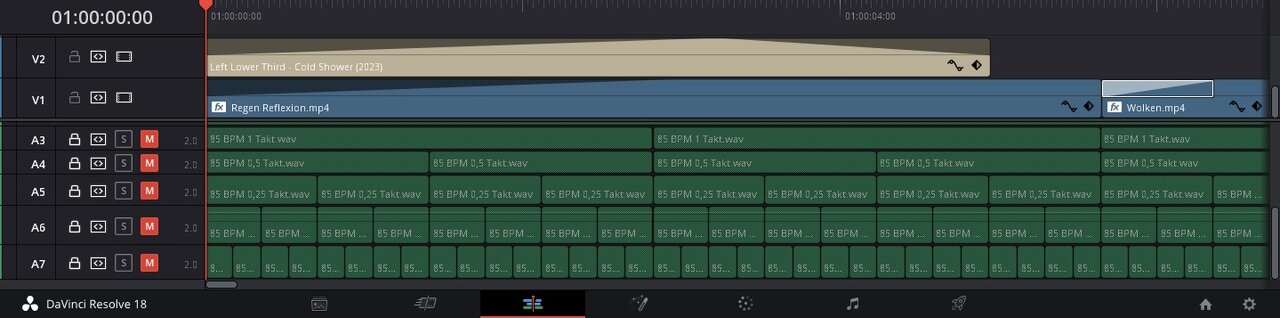

Also entschied ich mich das gleiche Prinzip mit Audio anzuwenden. In der DAW erstellte ich mir leere WAVs in der Länge von 1, 1/2, 1/4, 1/8 und 1/16 Takt, und setzte sie ins Projekt ein. Anders als bei Video, können Audios in DaVinci unabhängig von den FPS aneinander gereiht werden. Somit sind die Marker immer Synchron zum verwendeten Audio und man sieht sofort, wenn es mit den FPS nicht passt.

Das sieht dann so aus:

Und die Clips werden automatisch daran ausgerichtet (+/- ein Frame). Hier +1 Frame:

Anzumerken ist noch, dass man sich die Projektordner vorab anlegen soll. Jede Änderung des Dateinamens oder -Pfades von den Quellvideos sorgt für Fehlermeldungen im Projekt.

AUDIOFORMATE:

Ob die Audiomarker die identische Länge hätten, wenn ich sie als mp3 genommen hätte, kann ich nicht sagen, da ich zu faul bin es auszuprobieren. Wahrscheinlich gäbe es dort keine Abweichungen, da sie ja inhaltslos sind.

Mir ist jedoch ein Unterschied zwischen der mp3 und WAV Datei hinsichtlich des Inhaltes aufgefallen. Die Dateien waren gleich lang, aber die mp3 fing etwas später an. Gleichzeitig abgespielt, klang es wie ein Delay Effekt. Beim Vergrößern der Ansicht im Projektfenster, konnte man diese Abweichung auch deutlich erkennen. Am Anfang der Datei war eine kleine stumme Stelle und die Anschläge hatten einen sichtbaren Versatz gegenüber der WAV.

Somit sollte man von Anfang an mit WAVs arbeiten, denn bei einem Musikvideo sind es nicht nur die Schnitte selbst, die rhythmisch erfolgen sollten, sondern auch der Inhalt dazwischen. Durch den Versatz kann es schnell vorkommen, dass nach dem Audioaustausch die Bewegungen nicht mehr sitzen, wie sie sollten.

Am besten immer die Qualität nehmen, in der der Song auch produziert wurde, also den handelsüblichen WAV-Format mit 16/24/32(float) Bit und 44,1/48 kHz oder wie auch immer.

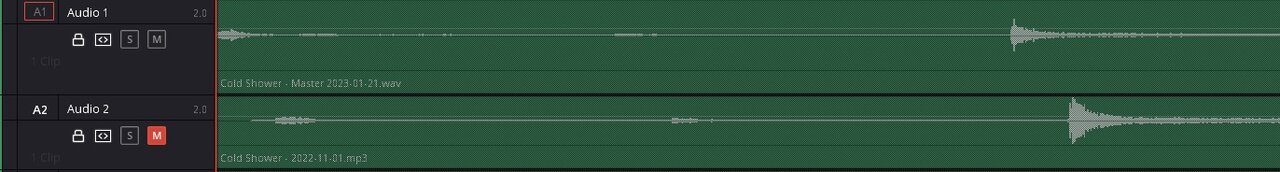

Hier der Unterschied zwischen mp3 und WAV:

DIE EIGENTLICHE ARBEIT:

Nachdem man das Videomaterial aufgenommen hat oder sich entsprechendes Material beschaffen hat, muss man sich mit den Inhalten vertraut machen. Den Song sollte man natürlich auch gut kennen, aber davon gehe ich aus, da dieser Erfahrungsbericht an die gerichtet ist, die eigene Werke visualisieren möchten.

Was man nun daraus macht und wie genau man vorgeht, dafür gibt es keine konkreten Vorgaben. Einen Workflow muss jeder für sich selbst finden und wie man die Schnitte setzt, obliegt der Kreativität des Einzelnen.

Es dürfte nicht schwer sein, im Netz entsprechende Tipps zu finden, wenn man denkt, dass man welche braucht. Ich halte mich dabei immer an den eigenen Geschmack. Wenn es mir gefällt, wird es womöglich auch jemand anderen gefallen, und was mir negativ bei anderen auffällt, das versuche ich nicht anzuwenden.

Das Programm selbst wird man erst kennenlernen, wenn man damit gearbeitet hat. Ich habe im ersten Video so viel wie möglich versucht einzubauen, damit ich mich mit den Funktionen vertraut mache. Beim nächsten Video kamen dann wieder neue Funktionen hinzu und beim Nächsten wieder etwas Neues, kombiniert mit dem Vertrauten.

Ich hoffe, dass ich behilflich sein konnte und wünsche viel Spaß bei der Videobearbeitung!

Hier noch der Link zu unserem Youtube-Kanal: https://www.youtube.com/@trivialdisorder

Edit (Bonus Gedanke):

Viele bauen die Lyrics direkt in das Video, als Untertitel, mit ein. Kann man machen. Man kann aber auch die Untertitelfunktion von Youtube nutzen. Haben wir bei unseren Videos auch gemacht.

VERWENDETE HARDWARE:

Windows 10

Intel i5-12500 3.00 GHz

Crucial RAM 16GB (2x 8GB) DDR5 4800MHz

MSI GeForce GTX 1650 4GT LP OC

Angefangen habe ich mit der Onboard Grafikkarte Intel UHD Graphics 770 und 8GB RAM. Das Hardwareupgrade war kein Quantensprung. In wie weit ich mit der neuen Grafikkarte besser fahre, muss noch geprüft werden. Eine Bessere steht mir derzeit nicht zur Verfügung, da ich einen kleinen Tower habe, sodass ich nur Grafikkarten im Low Profile Format einbauen kann, also steht nur der Vergleich an, ob ich mit der UHD 770 und mehr RAM doch nicht besser bedient bin. Bis irgendwann etwas nennenswert Besseres, in entsprechender Bauform, auf den Markt kommt.

Die RAM-Verdopplung hat nur marginale Verbesserungen gebracht. Bei Schnitten und/oder Übergängen von großen Videos, sowie beim Einsatz von umfangreicheren Effekten, gibt es weiterhin Ruckler und/oder Aussetzer im Vorschaufenster, weshalb ich hier mindestens 24GB empfehlen würde und selbst bei nächster Gelegenheit auf 32GB upgraden werde.

VERWENDETE SOFTWARE:

Vergangenes Jahr habe ich angefangen, mich näher mit der Videobearbeitung zu beschäftigen. Nachdem ich mehrere kostenlose Programme ausprobiert habe, fiel die Entscheidung auf DaVinci Resolve 18. Den Einstieg fand ich erstaunlich einfach. Kurzes Tutorial angeschaut, um die Struktur zu kapieren und schon konnte es losgehen.

DaVinci ist sehr aufgeräumt, umfangreich und logisch aufgebaut. Die Dosierung von Effekten sowie einfachen Funktionen wie Zoom, ist sehr schön gelöst, sodass man sie präzise setzen und kontrollieren kann. Selbst die kostenlose Version bietet genug hochwertige Effekte/Übergänge und Möglichkeiten der Farbanpassungen, sowie vieles mehr, was ich noch nicht kennengelernt/gebraucht habe. Bei meiner Arbeitsweise wäre der Kauf der Vollversion eine Geldverschwendung, wobei ich den Preis akzeptabel finde.

Die kostenlose Version ist gegenüber der Vollversion in manchen Sachen natürlich etwas eingeschränkt. In wie weit diese den eigenen Ansprüchen gerecht werden, muss individuell geprüft werden. Hierzu gibt es unzählige Webseiten und Videos, die diese Entscheidung erleichtern. Die für mich wichtigsten Punkte sind: Die Einschränkung auf max. 60 FPS und 4K.

Projektfenster von "Cold Shower":

EIGENARTEN DIESER SOFTWARE:

Wie jede andere Software, bringt auch DaVinci Resolve 18 einige Eigenarten mit. Wenn man es gewohnt ist, mit der ENTF-Taste zu löschen, sollte man sich bei "Keyboard Customization" einstellen, dass diese Taste den "Selected Delete" anstatt "Ripple Delete" ausführt. Beim Letzteren entsteht nämlich keine Lücke nach dem Löschen, sondern die nachfolgenden Videos rutschen nach, was logischerweise das ganze Projekt durcheinander bringt. Dieses Missgeschick in der Verbindung mit dem "Live Save" sorgte mal dafür, dass ich ein Projekt neu anfangen musste. Danach schaltete ich "Live Save" aus und aktivierte stattdessen die Backups. Wer schon länger mit dem PC arbeitet, wird den STRG+S Befehl verinnerlicht haben und braucht diesen Automatismus, bei dem es kein Zurück mehr gibt, nicht.

Meiner Internetrecherche nach, hat DaVinci nicht gerade den besten H.264 Codec an Board. Dies macht sich bei schnellen Helligkeitswechseln bemerkbar. Die gerenderten Videos weisen an solchen Stellen grobe Pixel auf. Einige vermeintlichen Experten auf YouTube raten es ins Quicktime Format, mit dem Codec DNxHD oder DNxHR zu rendern, und es anschließend mit einer anderen Software in mp4 H.264 umzuwandeln. Ich bin aber kein Freund von Umwandlungen.

Einfacher und qualitativ besser geht es indem man bei den Rendereinstellungen die Key Frames auf "Every 1 Frame" setzt. Dadurch wird zwar die Datei doppelt so groß, aber fehlerfrei, ohne dass man sie vergewaltigt. So als Orientierung: Ein Musikvideo in HD Qualität (1080p), mit ca. 3,5min Länge, wäre dann ca. 1GB groß. In der heutigen Zeit dürfte das zu verkraften sein.

Diese Einstellung findet man hier:

So sieht ein Blitzeinschlag aus, wenn man die Key Frames nicht auf 1 gesetzt hat:

MEINE ARBEITSWEISE:

Da ich für eigene Aufnahmen keine Zeit, Lust, Erfahrung, Ausrüstung, Helfer u.a. habe, entschied ich mich unsere Musikvideos mit dem, in Netz frei verfügbaren, Videomaterial zu schneiden. Momentan bin ich bei der Fertigstellung des dritten Musikvideos. Das Erste ist seit November 2022 auf YouTube, das Zweite seit Mitte Februar 2023 und das Dritte kommt irgendwann, wenn der Song so weit wird.

Mit fremdem Material etwas Eigenes zu machen, kann sowohl sehr einfach, als auch sehr kompliziert sein. Je nachdem welche Ziele man sich setzt. Einfach ist es in dem Sinne, dass man nichts selbst drehen muss und somit ein großer, schwerer, zeitaufwändiger und fast wichtigster Aufgabenteil wegfällt. Kompliziert wird es dann, wenn nicht genug passendes Material gefunden wird. Das Material zusammenzusuchen ist eine Fleißarbeit und alles so zu schneiden, dass es halbwegs stimmig aussieht, ist oft eine Glückssache. Den Kommentaren zufolge, die ich zu den Videos bekam, scheint mir dieser Spagat gelungen zu sein, aber das ist oft Geschmackssache. Ich selbst finde sie für den vorgesehenen Zweck ok.

HABEN SIE VERSTÄNDNIS FÜR FPS:

Ein Musikvideo zeichnet sich unter anderem dadurch aus, dass die Clips im Rhythmus geschnitten sind, also die Schnitte im Beat erfolgen, und ein Videobearbeitungsprogramm zeichnet sich dadurch aus, dass er in FPS (Bilder pro Sekunde) arbeitet. Anders als in der DAW, wo man in BPM arbeitet und dennoch sehr feine Einstellungen vornehmen kann, erlauben die Videoprogramme tatsächlich nur so viele Schnitte in der Sekunde, wie sie im Projekt eingestellt sind.

Bei 30, 60, 120, 180 oder 240BPM sind diese beiden Einheiten synchronisiert und es kann so gut wie nichts schief laufen. Doch sobald man davon abweicht, muss man Kompromisse eingehen und den Schnitt etwas vor- oder zurücksetzen. Also: Je mehr FPS in der Videobearbeitung zugelassen sind, umso präziser können die Schnitte gesetzt werden.

Wie bereits erwähnt, kann man in der kostenlosen Version von DaVinci Resolve 18 max. 60FPS einstellen. Das ist gerade so genug, um einigermaßen genau arbeiten zu können.

ARBEITSERLEICHTERUNG:

Es kann unglaublich nervig und unnötig zeitaufwendig sein, die Clips manuell auf die passende Länge zu schneiden und/oder auf die richtige Position zu platzieren, weshalb man sich zuallererst Gedanken darüber machen sollte, wie man sich die Arbeit vereinfachen kann.

Vor ca. 15 Jahren, als ich kurz mit Adobe Premiere experimentierte, wurde mir empfohlen die Marker im Beat zu setzen. Wenn ich mich richtig erinnere, erfolgte das so, dass man die Audiodatei einfügte, Play drückte und dort wo die Schnitte hinkommen sollten, die Taste M drückte. Später durfte man die ungenauen Marker zurechtrücken oder löschen und neu setzen. Meine Begeisterung für diese Empfehlung hielt sich in Grenzen, da es aber nur ein kleines Videoprojekt mit wenigen solchen Schnitten war, nahm ich sie an, doch beim Wiedereinstieg in die Videobearbeitung musste eine neue Lösung her.

Die Empfehlung die ich diesmal bekam war besser, aber immer noch nicht ideal. Ich sollte mir inhaltslose Videosequenzen in der entsprechenden Länge erstellen, sie im Projekt nacheinander reihen und als Marker verwenden. Eigentlich eine ganz gute Idee, aber auf die Umrechnung und zusätzliche Videos in der Timeline hatte ich keine Lust. Außerdem bestand ja weiterhin das Problem mit der Ungenauigkeit aufgrund von FPS.

Also entschied ich mich das gleiche Prinzip mit Audio anzuwenden. In der DAW erstellte ich mir leere WAVs in der Länge von 1, 1/2, 1/4, 1/8 und 1/16 Takt, und setzte sie ins Projekt ein. Anders als bei Video, können Audios in DaVinci unabhängig von den FPS aneinander gereiht werden. Somit sind die Marker immer Synchron zum verwendeten Audio und man sieht sofort, wenn es mit den FPS nicht passt.

Das sieht dann so aus:

Und die Clips werden automatisch daran ausgerichtet (+/- ein Frame). Hier +1 Frame:

Anzumerken ist noch, dass man sich die Projektordner vorab anlegen soll. Jede Änderung des Dateinamens oder -Pfades von den Quellvideos sorgt für Fehlermeldungen im Projekt.

AUDIOFORMATE:

Ob die Audiomarker die identische Länge hätten, wenn ich sie als mp3 genommen hätte, kann ich nicht sagen, da ich zu faul bin es auszuprobieren. Wahrscheinlich gäbe es dort keine Abweichungen, da sie ja inhaltslos sind.

Mir ist jedoch ein Unterschied zwischen der mp3 und WAV Datei hinsichtlich des Inhaltes aufgefallen. Die Dateien waren gleich lang, aber die mp3 fing etwas später an. Gleichzeitig abgespielt, klang es wie ein Delay Effekt. Beim Vergrößern der Ansicht im Projektfenster, konnte man diese Abweichung auch deutlich erkennen. Am Anfang der Datei war eine kleine stumme Stelle und die Anschläge hatten einen sichtbaren Versatz gegenüber der WAV.

Somit sollte man von Anfang an mit WAVs arbeiten, denn bei einem Musikvideo sind es nicht nur die Schnitte selbst, die rhythmisch erfolgen sollten, sondern auch der Inhalt dazwischen. Durch den Versatz kann es schnell vorkommen, dass nach dem Audioaustausch die Bewegungen nicht mehr sitzen, wie sie sollten.

Am besten immer die Qualität nehmen, in der der Song auch produziert wurde, also den handelsüblichen WAV-Format mit 16/24/32(float) Bit und 44,1/48 kHz oder wie auch immer.

Hier der Unterschied zwischen mp3 und WAV:

DIE EIGENTLICHE ARBEIT:

Nachdem man das Videomaterial aufgenommen hat oder sich entsprechendes Material beschaffen hat, muss man sich mit den Inhalten vertraut machen. Den Song sollte man natürlich auch gut kennen, aber davon gehe ich aus, da dieser Erfahrungsbericht an die gerichtet ist, die eigene Werke visualisieren möchten.

Was man nun daraus macht und wie genau man vorgeht, dafür gibt es keine konkreten Vorgaben. Einen Workflow muss jeder für sich selbst finden und wie man die Schnitte setzt, obliegt der Kreativität des Einzelnen.

Es dürfte nicht schwer sein, im Netz entsprechende Tipps zu finden, wenn man denkt, dass man welche braucht. Ich halte mich dabei immer an den eigenen Geschmack. Wenn es mir gefällt, wird es womöglich auch jemand anderen gefallen, und was mir negativ bei anderen auffällt, das versuche ich nicht anzuwenden.

Das Programm selbst wird man erst kennenlernen, wenn man damit gearbeitet hat. Ich habe im ersten Video so viel wie möglich versucht einzubauen, damit ich mich mit den Funktionen vertraut mache. Beim nächsten Video kamen dann wieder neue Funktionen hinzu und beim Nächsten wieder etwas Neues, kombiniert mit dem Vertrauten.

Ich hoffe, dass ich behilflich sein konnte und wünsche viel Spaß bei der Videobearbeitung!

Hier noch der Link zu unserem Youtube-Kanal: https://www.youtube.com/@trivialdisorder

Edit (Bonus Gedanke):

Viele bauen die Lyrics direkt in das Video, als Untertitel, mit ein. Kann man machen. Man kann aber auch die Untertitelfunktion von Youtube nutzen. Haben wir bei unseren Videos auch gemacht.

Zuletzt bearbeitet: