ars ultima schrieb:

Das linke Bild hat eine Auflösung von 640x480.

Das rechte hat eine Auflösung von 800x600.

Welches ist schärfer?

Das linke Bild is hier schärfer aber:

Es sieht so aus, als wäre das rechte Bild auch 640x480 Auflösung nur allgemein größer dargestellt oder aufgezoomt (So als wenn i z.B. im Windows Wallpaper Strecken einstelle, damit sich ein Bild über das gesamte Display betrachten läßt, aber es trotzdem die gleiche ursprüngliche Auflösung hat)

Ein Monitor mit ner Auflösung von 800x600 mit 85Hz ist schärfer als die Einstellung mit 640x480 mit auch 85Hz!

Schau dir z. B. games an, zock mal mit 800x600 (z.B. 85Hz) Auflösung, meinetwegen noch mit AA und stelle mal 1600x1200 (z.B. 85Hz) ein ohne AA, welches Bild is wohl besser?

I mein mal des höher Aufgelöste!

Nehmen wir mal den gleichen Monitor sogar mit ner sehr geringen Lochmaske ums zu verdeutlichen...

I kann es mir net vorstellen, das ne höhere Auflösung matschiger (bei gleicher Frequenz und Monitor, klar) sein soll, i IMHO quatsch.

Hab schon viel gesehen, aber des noch net...

Wenn das Bild bei dir dann matschig is, i putz manchmal meine Monitore...*g*...

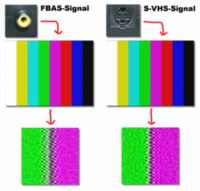

Noch nen Vergleich:

Zock mal ne Weile (3-4h) am PC ein gutes Spiel in z.B. 1280x1024 bei 85Hz

schau dir danach mal nen handelüblichen TV an mit ner Auflösung von was au immer die einfachen haben (weiß net genau, gibt ja au bessere, aber z.B. 640x480 wenns hoch kommt)...Da ist des TV Bild auf einmal total schwammig un unscharf , weil sich deine Augen an die hohe Auflösung und Details am Monitor gewöhnt haben( sozusagen die wurden verwöhnt)...un jetz was schlechteres sehen....

Noch eins:

Videofilme: Schau dir mal VCD-Qualität an un SVCD-Qualität...da is wohl ein großer Unterschied zu sehen...Welches der Beiden Formate hat hier wohl ne höhere Auflösung?

Soviel dazu...

Es gibt wie schon gesagt, viele GRünde für ein gutes Bild oder net, aber höhere Auflösung is nunmal schärfer!

Noch eins:

Stichwort: Digicam!

Mach mal nen Foto mit ner 2MegaPixel-Kamera un mit ner 5Mega-Pixel und lass dir dann mal ein Poster davon ausdrucken (z.B.1100x700)

Mit welcher Kamera is nu das Poster schärfer?

gruß Corvus