Lum

Registrierter Benutzer

- Zuletzt hier

- 04.07.25

- Registriert

- 05.05.05

- Beiträge

- 3.477

- Kekse

- 71.949

(@mods, sollte das in den howto Bereich wandern, wäre ich sehr verbunden wenn ihr den Einstiege-Thread vom NAM UserThread mit einem Link zu diesem HowTo versehen könntet  )

)

Hi Zusammen,

eine super kurze Anleitung wie ihr NAM (Neural Amp Modeler) in Windows aufsetzen könnt. Das ganze dauert 3 Minuten!

UserThread mit user-profilen (einige von mir) findet ihr hier

Etwas Kontext (könnt ihr skippen, wenn ihr nur schnell das Plugin ausprobieren wollt)

NAM beruht auf neuen Machine Learning Verfahren (WaveNet) und bietet die aktuell akkurateste digitale Abbildung von echten Verstärkern ab, kostenlos!

Dabei werden im Trainingsprozess des Modells ein Neuronales Netzwerk trainiert (ungefähr ähnlich wie chatGPT, aber eben keine transformer-architektur).

Der Trainingsprozess kostet einiges an Leistung (am schnellsten auf GPUs), daher wird zumindest das Training selbst einige Zeit lang nicht physischen Geräten (wie Quad Cortex, Kemper, ToneX) zur Verfügung liegen.

Das Training selbst kann ich auch gerne noch beschreiben, da ich alle meine Amps selbst lokal (mit meiner RTX 4090 ) trainiert habe mit 500-2000 Epochs mit ReAmping Box für die besten Ergebnisse.

) trainiert habe mit 500-2000 Epochs mit ReAmping Box für die besten Ergebnisse.

Ich kann jedem hier nur empfehlen die 3 Minuten zu investieren um es zumindest mal auszuprobieren. Die Qualität ist schlicht und einfach perfekt.

Wenn ich etwas Zeit habe, lade ich gerne A/B Vergleiche hoch, aber selbst das feeling beim Spielen ist für mich 100% gleich zum echten Amp.

---------------------------------------------------

LOS GEHT'S

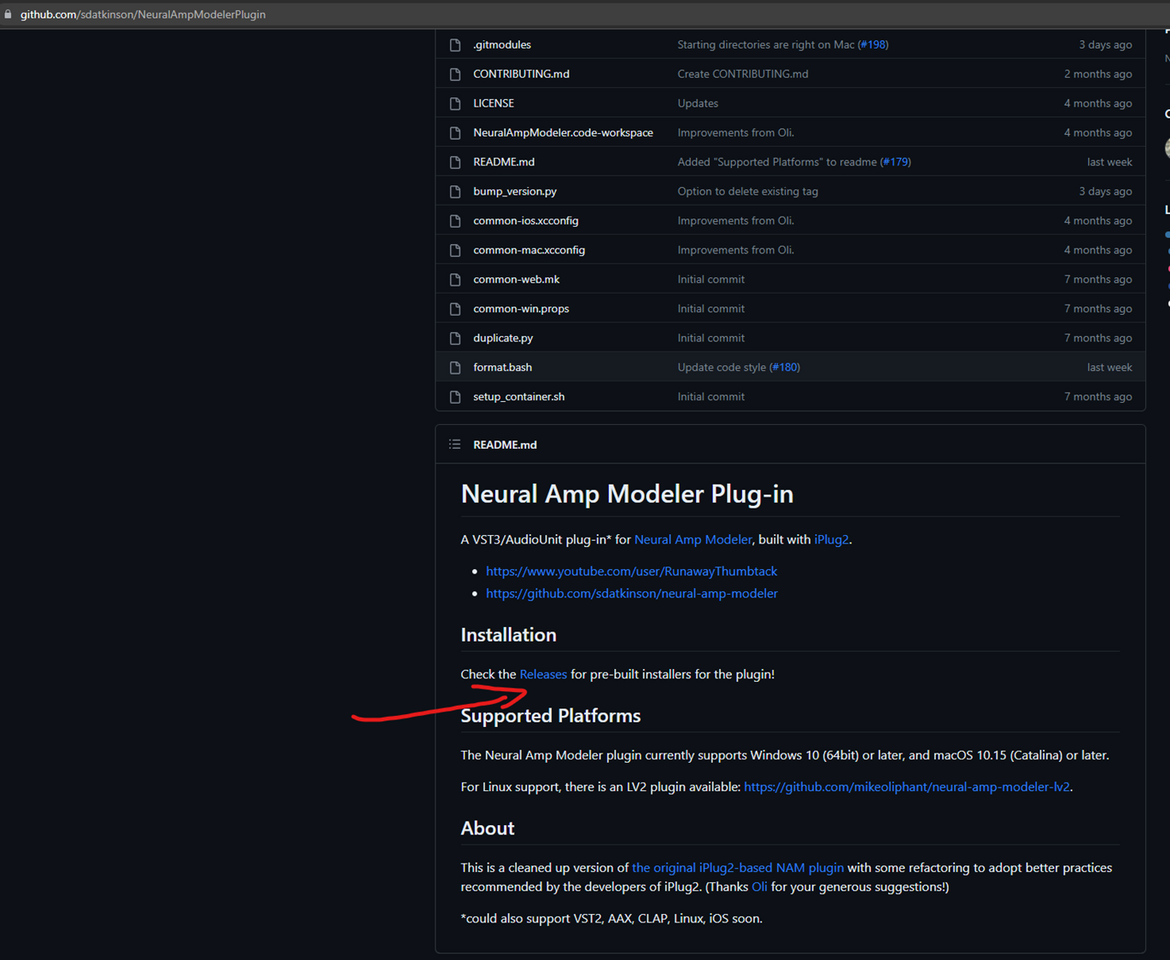

Geht auf die github-Seite des NAM Plugins

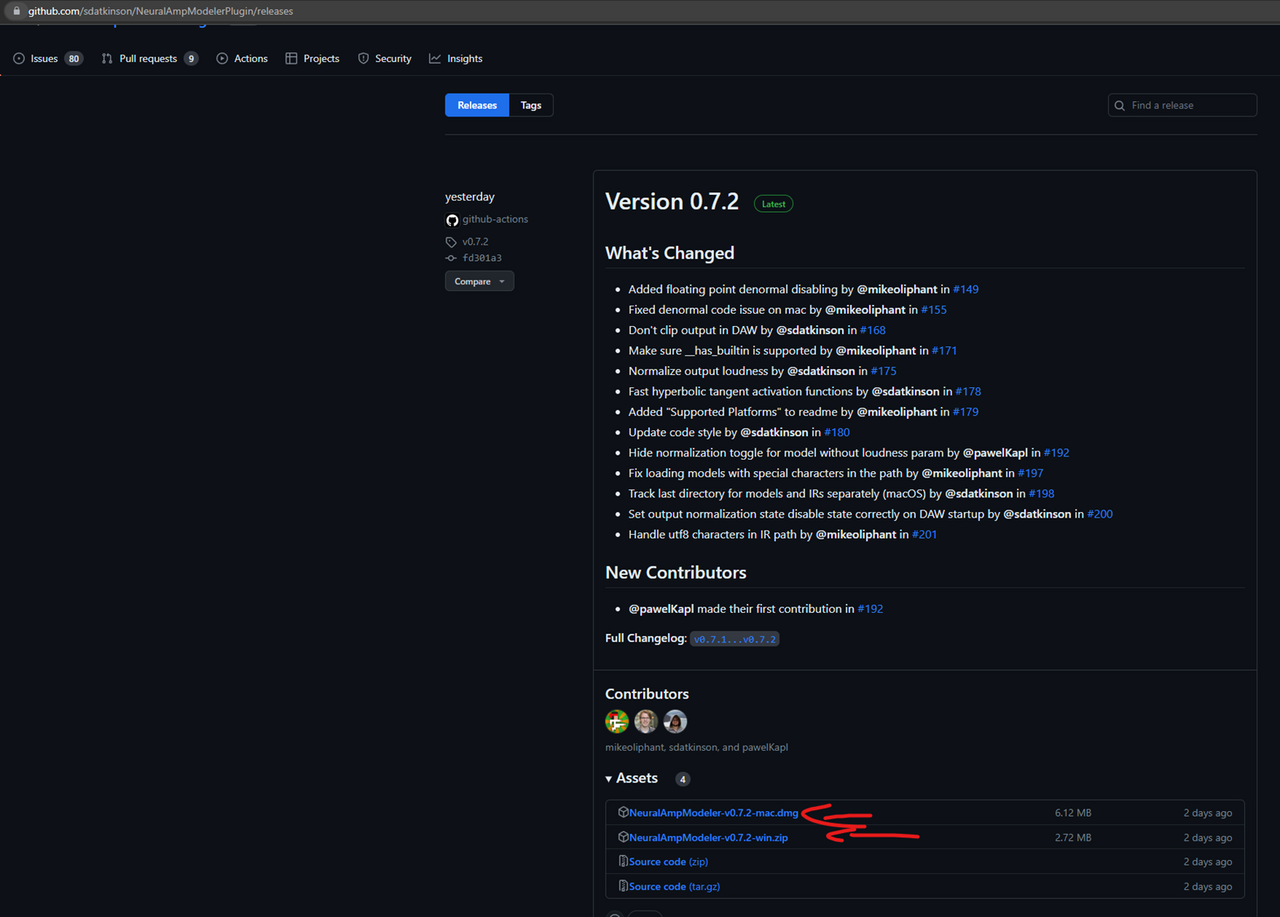

Ladet den Installer (unter Assets) für windows oder mac runter

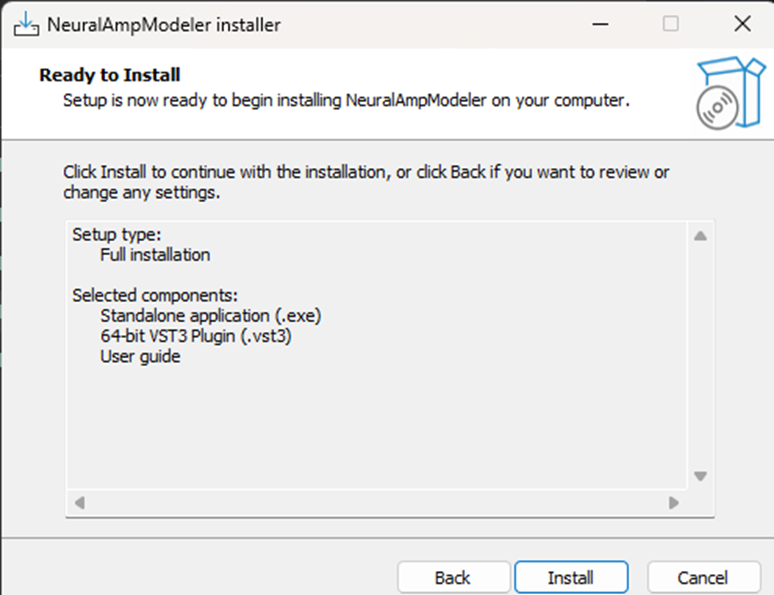

Führt den Installer aus und klickt next (wichtig ist mMn nur das VST3 Plugin)

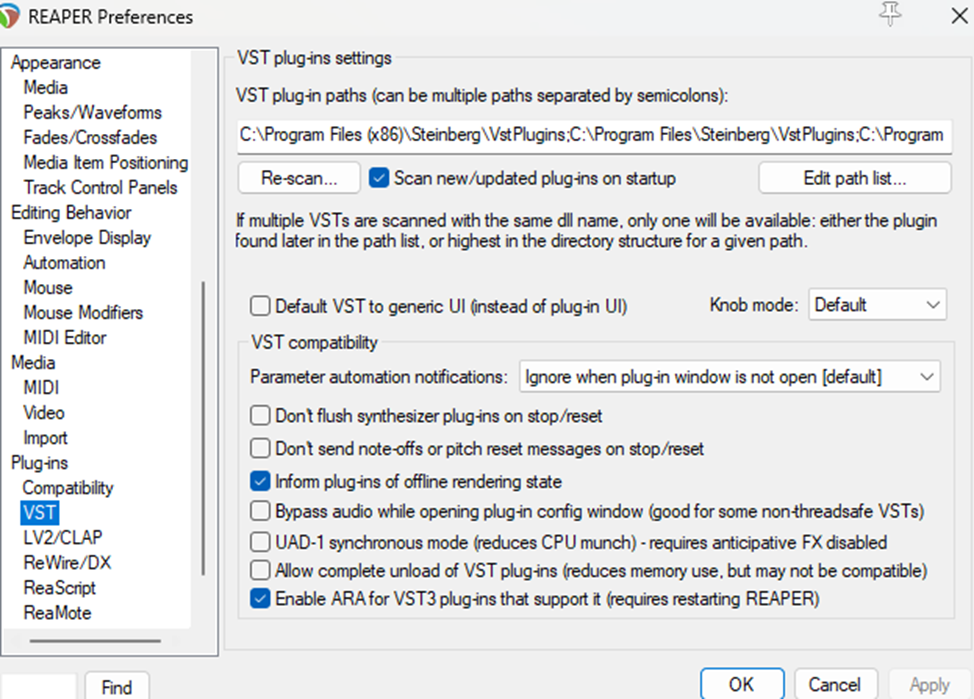

Stellt sicher dass das VST Plugin in einem Ordner liegt, welches von eurer DAW (Reaper, Cubase, Ableton, ...) gescanned wird.

Unter Reaper stehen diese hier:

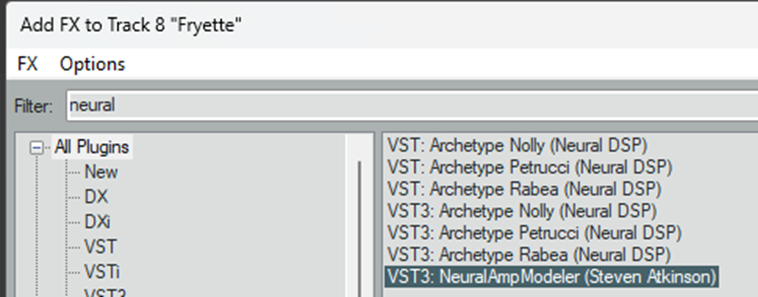

Fügt zu eurer AudioSpur, welche als Input euren Kanal hat, wo eure Gitarre reingeht, einen FX / Effekt hinzu (hier tauchen nun alle registrierten erkannten VST Plugins auf. Sollte NAM nicht auftauchen einfach nochmal scannen lassen oder den Pfad im letzten Schritt überprüfen)

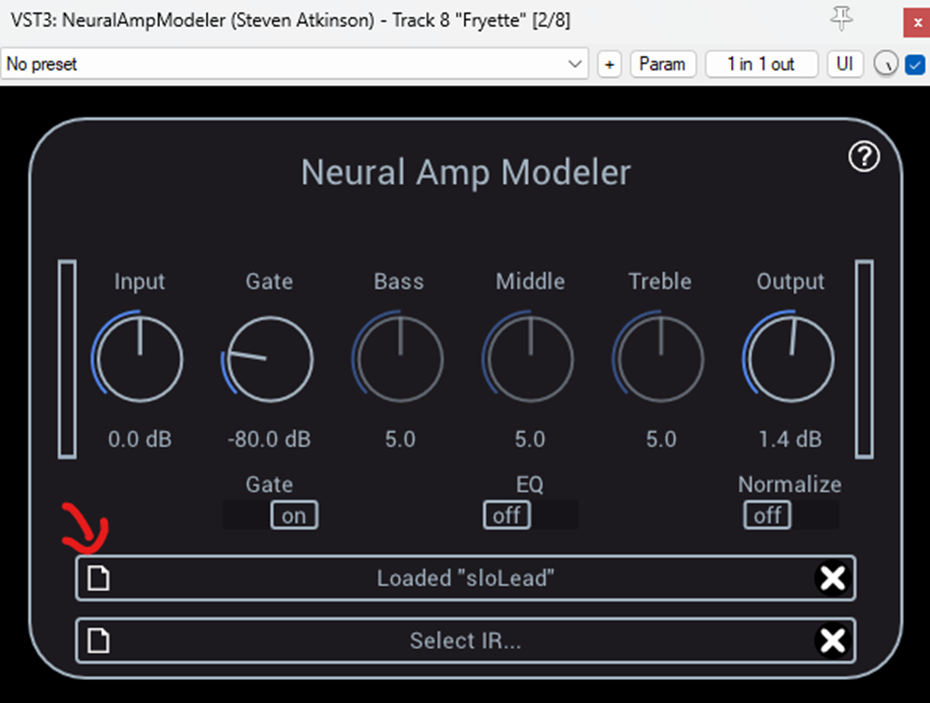

Ladet in NAM eine AmpSim (auf den Ordern Klicken und eine .nam file auswählen. Im UserThread habe ich einige meiner Amps schon hochgeladen)

Jetzt braucht ihr nur noch eine CabSim / IR (Impulse Response)

Hier gibt es kostenlose (auf youtube einfach suchen) welche ihr mit einem IR Loader danach hinzufügt (unter Reaper ist ReaVerb der kostenlose IR Loader). .

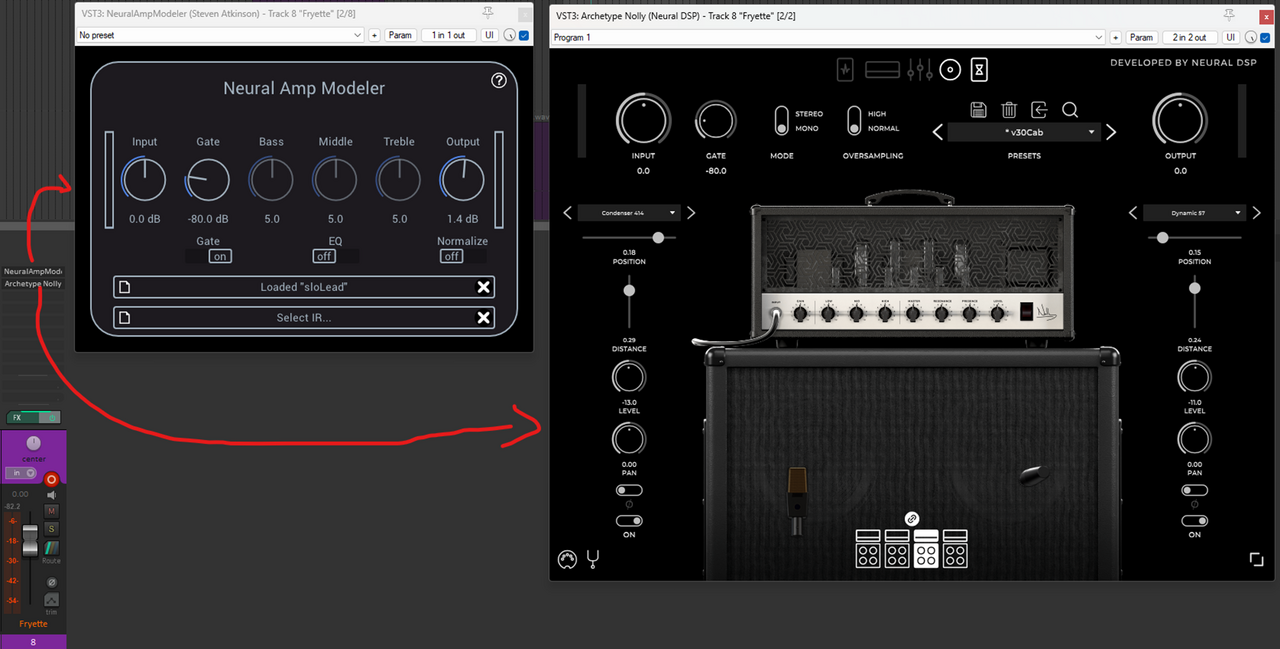

Ich persönlich empfehle Neural DSP Nolly: ihr habt ihr ein einfaches Plugin welches ihr Standalone nutzen könnt, oder nur die Booster-Section, nur die IR Section, oder nur Reverb / Delay.

Kann man kostenlos 2 Wochen testen.

Alternativ könnt ihr euch auch das Tutorial von @Fischi reinziehen und eigene IR bauen!

Am Ende sieht eure Signal-Chain so aus:

D.h. man investiert einmal etwas Geld in CabSims/IR (ich empfehle neural DSP oder GGD (get good drums) Cali / Zilla) und die NAM Amps sowie plugin sind 100% kostenlos.

Eine gute CabSim ist übrigens, wie auch im analogen Leben, sehr sehr wichtig. Speaker, Mics und co formen den Sound erheblich.

Bei Fragen schießt einfach los.

Hi Zusammen,

eine super kurze Anleitung wie ihr NAM (Neural Amp Modeler) in Windows aufsetzen könnt. Das ganze dauert 3 Minuten!

UserThread mit user-profilen (einige von mir) findet ihr hier

Etwas Kontext (könnt ihr skippen, wenn ihr nur schnell das Plugin ausprobieren wollt)

NAM beruht auf neuen Machine Learning Verfahren (WaveNet) und bietet die aktuell akkurateste digitale Abbildung von echten Verstärkern ab, kostenlos!

Dabei werden im Trainingsprozess des Modells ein Neuronales Netzwerk trainiert (ungefähr ähnlich wie chatGPT, aber eben keine transformer-architektur).

Der Trainingsprozess kostet einiges an Leistung (am schnellsten auf GPUs), daher wird zumindest das Training selbst einige Zeit lang nicht physischen Geräten (wie Quad Cortex, Kemper, ToneX) zur Verfügung liegen.

Das Training selbst kann ich auch gerne noch beschreiben, da ich alle meine Amps selbst lokal (mit meiner RTX 4090

Ich kann jedem hier nur empfehlen die 3 Minuten zu investieren um es zumindest mal auszuprobieren. Die Qualität ist schlicht und einfach perfekt.

Wenn ich etwas Zeit habe, lade ich gerne A/B Vergleiche hoch, aber selbst das feeling beim Spielen ist für mich 100% gleich zum echten Amp.

---------------------------------------------------

LOS GEHT'S

Geht auf die github-Seite des NAM Plugins

Ladet den Installer (unter Assets) für windows oder mac runter

Führt den Installer aus und klickt next (wichtig ist mMn nur das VST3 Plugin)

Stellt sicher dass das VST Plugin in einem Ordner liegt, welches von eurer DAW (Reaper, Cubase, Ableton, ...) gescanned wird.

Unter Reaper stehen diese hier:

Fügt zu eurer AudioSpur, welche als Input euren Kanal hat, wo eure Gitarre reingeht, einen FX / Effekt hinzu (hier tauchen nun alle registrierten erkannten VST Plugins auf. Sollte NAM nicht auftauchen einfach nochmal scannen lassen oder den Pfad im letzten Schritt überprüfen)

Ladet in NAM eine AmpSim (auf den Ordern Klicken und eine .nam file auswählen. Im UserThread habe ich einige meiner Amps schon hochgeladen)

Jetzt braucht ihr nur noch eine CabSim / IR (Impulse Response)

Hier gibt es kostenlose (auf youtube einfach suchen) welche ihr mit einem IR Loader danach hinzufügt (unter Reaper ist ReaVerb der kostenlose IR Loader). .

Ich persönlich empfehle Neural DSP Nolly: ihr habt ihr ein einfaches Plugin welches ihr Standalone nutzen könnt, oder nur die Booster-Section, nur die IR Section, oder nur Reverb / Delay.

Kann man kostenlos 2 Wochen testen.

Alternativ könnt ihr euch auch das Tutorial von @Fischi reinziehen und eigene IR bauen!

Am Ende sieht eure Signal-Chain so aus:

D.h. man investiert einmal etwas Geld in CabSims/IR (ich empfehle neural DSP oder GGD (get good drums) Cali / Zilla) und die NAM Amps sowie plugin sind 100% kostenlos.

Eine gute CabSim ist übrigens, wie auch im analogen Leben, sehr sehr wichtig. Speaker, Mics und co formen den Sound erheblich.

Bei Fragen schießt einfach los.

Zuletzt bearbeitet: